La adopción de buscadores y asistentes de IA, como ChatGPT, Perplexity o Gemini, crece sin pausa en empresas de todo tipo, impulsando la productividad y la generación de contenido en tiempo real. Sin embargo, según Cisco, el 97% de las organizaciones siente presión por integrar IA y el 68% reconoce no estar preparado ante sus riesgos de seguridad.

¿Qué es la privacidad dentro de la inteligencia artificial?

La privacidad en IA consiste en garantizar que los datos personales y corporativos empleados en buscadores y asistentes inteligentes se recojan, procesen y almacenen de forma segura y acorde con la normativa vigente.

Bajo el Reglamento General de Protección de Datos (RGPD), toda información identificable debe tratarse con licitud, transparencia y minimización. Además, los interesados tienen derecho a acceder, rectificar o suprimir sus datos incluso cuando se utilizan modelos de IA alojados en la nube.

Los principios de la privacidad en inteligencia artificial

Para proteger datos en herramientas de IA es conveniente basarse en un conjunto de principios que guíen tanto el diseño como el uso continuo de estas soluciones:

• Minimización: solo enviar a la IA el dato estrictamente necesario.

• Anonimización y pseudonimización: sustituir identificadores directos por códigos o claves.

• Transparencia: informar a usuarios y clientes sobre qué información se comparte y para qué fines.

• Responsabilidad proactiva: documentar procesos, registrar consentimientos y mantener auditorías periódicas.

• Privilegio mínimo: conceder a cada usuario o servicio únicamente los permisos imprescindibles.

¿Por qué proteger la privacidad en IA es esencial?

Proteger la privacidad en IA no solo evita sanciones, sino que refuerza la reputación y genera confianza entre clientes, socios y empleados. Según ENISA, el 85% de las brechas relacionadas con IA provienen de configuraciones inseguras en proveedores externos, lo que evidencia el peligro de delegar sin control. Adoptar buenas prácticas desde el inicio mejora la resiliencia corporativa ante incidentes.

La Agencia Española de Protección de Datos ha impuesto multas de hasta el 4% de la facturación global por incumplimientos graves en protección de datos, lo que subraya la necesidad de un enfoque proactivo. El cifrado de la información, la segmentación de accesos y las auditorías periódicas son medidas clave para minimizar riesgos. De este modo, tu empresa demuestra un manejo responsable de los datos y se diferencia en el mercado.

¿Cómo aplicar buenas prácticas de privacidad en IA?

A continuación, un listado de medidas organizativas y técnicas que toda empresa debería implementar antes de exponer datos sensibles a buscadores o asistentes inteligentes:

- Gobernanza de datos:

• Crear un comité interno de IA con CISO, DPO y responsables de cada área.

• Definir un catálogo de casos de uso autorizados y aprobar flujos de trabajo.

- Segmentación de entornos:

• Separar desarrollo, test y producción para evitar fugas accidentales.

• Aplicar el principio de “least privilege” en roles y permisos.

- Minimización y anonimización:

• Enviar a la IA solo el fragmento de texto o dato estrictamente necesario.

• Utilizar herramientas de anonimización antes de compartir ficheros.

- Contratos y auditorías a proveedores:

• Verificar certificaciones (ISO 27001, ENS) y exigir auditorías semestrales.

• Incluir cláusulas de confidencialidad y reversión de datos al finalizar el servicio.

- Formación continua:

• Capacitar a usuarios en identificación de prompts maliciosos y protocolos de reporte.

• Realizar simulacros trimestrales de respuesta ante incidentes.

Beneficios de proteger la privacidad en la inteligencia artificial

Implementar estas buenas prácticas no solo minimiza el riesgo de sanciones y fugas, sino que:

• Refuerza la confianza de clientes y socios al demostrar un compromiso real con la seguridad.

• Mejora la calidad de los modelos al eliminar ruido y datos innecesarios.

• Facilita auditorías y demuestra cumplimiento frente a organismos reguladores.

• Potencia la innovación, al liberar a los equipos de la carga de gestionar incidentes y responder a crisis.

IA aplicada a la ciberseguridad y Seguridad en IA

La seguridad de la IA se ocupa de blindar tus modelos, datos y entornos de ejecución mediante cifrado, segmentación de redes, pruebas adversariales y monitorización continua, para evitar manipulación del sistema y fugas de información.

En cambio, la IA aplicada a la ciberseguridad utiliza esos mismos motores de análisis para supervisar y correlacionar eventos de red, endpoints y logs, generando alertas y respuestas automáticas que detectan y mitigan ataques en toda la infraestructura.

Situaciones en las que la IA puede exponer tu información privada

- Consultas con datos de clientes: al pedir al asistente que redacte emails, genere informes o resuma llamadas incluyendo nombres, correos electrónicos, teléfonos o cualquier dato personal, esos datos se transmiten y almacenan en los servidores del proveedor, quedando expuestos a acceso no deseado.

- Entrenamiento con documentos confidenciales: algunos usuarios suben contratos, nóminas o expedientes médicos para que la IA extraiga conclusiones o cree resúmenes. Si esos archivos no están anonimizados correctamente, la herramienta puede retener información sensible y reutilizarla en futuras respuestas.

- Exposición de historiales de chat: al no borrar el registro de conversaciones, cualquier persona con acceso a la cuenta (o a la misma sesión) puede revisar intercambios anteriores que contienen datos estratégicos, secretos comerciales o comunicaciones internas.

- Compartir enlaces o rutas de acceso: incluir en el prompt enlaces a repositorios internos, carpetas compartidas o APIs protegidas puede permitir que la IA rastree y exponga información de esos recursos, generando potenciales fugas masivas de datos.

- Uso de datos reales en entornos de prueba: para probar integraciones o plugins de IA, se emplean con frecuencia datos de producción (clientes, empleados, proveedores). Si no se aíslan debidamente los entornos de test, esos datos pueden filtrarse o indexarse fuera de control.

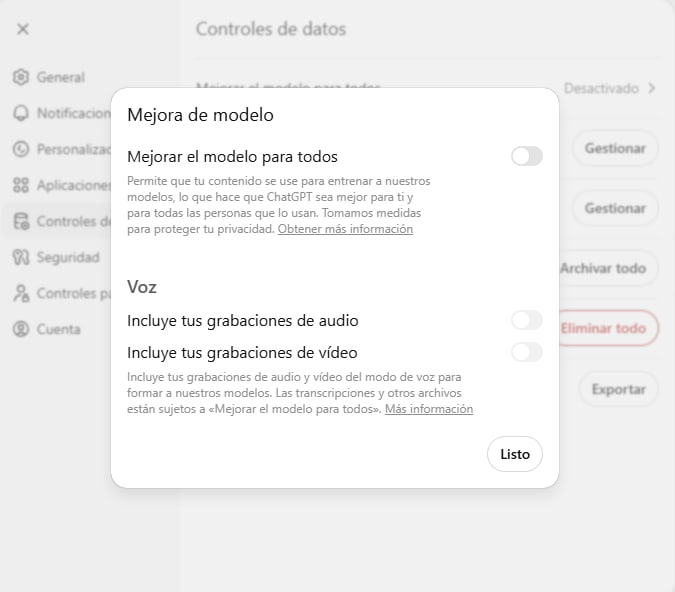

Guía rápida de configuración segura en buscadores y asitentes inteligentes

Para blindar tus interacciones con la IA, lleva a cabo estos ajustes básicos en cualquier plataforma de IA que utilices:

- Accede a Ajustes → Privacidad o Datos y desactiva “Usar mis datos para entrenar modelos”.

- Programa el borrado automático de historiales tras un periodo prudencial (por ejemplo, 30 días).

- Revisa las integraciones API y bloquea cargas masivas de información no esencial.

- Habilita la autenticación de dos factores y audita permisos de aplicaciones de terceros.

- Centraliza logs en un sistema SIEM y configura alertas ante patrones anómalos de uso.

La IA conversacional y los buscadores inteligentes ofrecen enormes ventajas, pero solo si los usamos con cabeza. Con un plan sencillo de buenas prácticas y controles básicos podrás disfrutar de sus beneficios sin exponer tu información. Si quieres obtener más información, estamos aquí para ayudarte.